산업기술

비행 시간 센서는 어떻게 거리를 결정합니까? 예시 3D 카메라를 사용하여 ToF 카메라에 대해 자세히 알아보세요.

휴대폰과 자동차의 공간을 놓고 경쟁하는 세 가지 주요 3D 이미징 기술이 있습니다. 이러한 기술은 입체 이미징, 구조화된 광 프로젝션 및 ToF(Time-of-Flight) 카메라입니다. 이러한 장치가 생성하는 데이터는 보행자 감지를 제공하고, 얼굴 특징을 기반으로 사용자를 인증하고, 손 움직임을 감지하고, SLAM(동시 위치 파악 및 매핑) 알고리즘을 제공할 수 있습니다.

이 분야에서 가장 큰 두 회사는 ams와 Infineon입니다. 작성 당시 ams는 각 유형의 센서를 하나씩 보유하고 있으며 Infineon은 ToF(time-of-flight) 센서에만 중점을 둡니다.

이 기사에서는 pmdtechnologies의 3D 카메라 개발 키트 "pico flexx"에 초점을 맞춰 ToF(time-of-flight) 센서 이면의 기술을 설명합니다. (묻기 전에 "pico flexx"와 "pmdtechnologies"는 웹사이트에서 모두 소문자로 표시됩니다.)

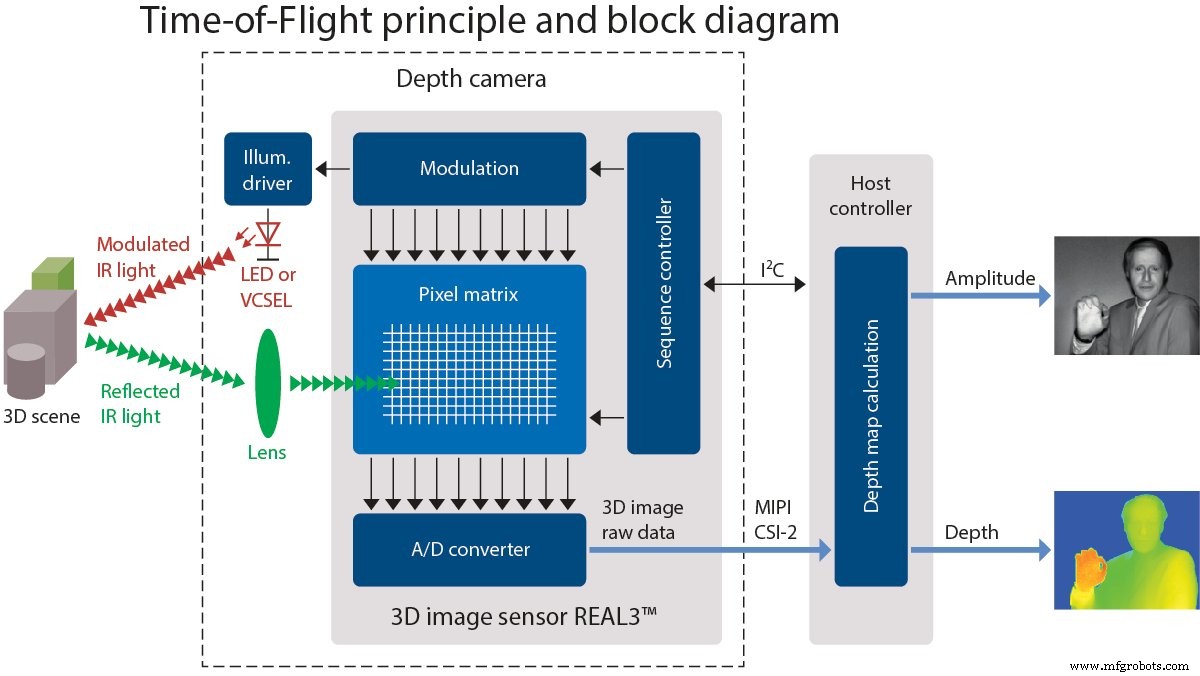

Pico flexx는 Infineon과 pmd가 공동 개발한 3D 이미지 센서 REAL3를 기반으로 구축되었습니다.

pmd는 이 기사를 위해 우리에게 장치를 제공했습니다.

비행 시간 센서는 매체를 통해 거리를 이동하는 데 걸리는 시간을 측정합니다. 일반적으로 이것은 파동 펄스의 방출, 물체의 반사 및 ToF 센서로의 복귀 사이에 경과된 시간을 측정한 것입니다. 비행 시간 카메라는 ToF 측정을 활용하여 카메라와 물체 또는 환경 사이의 거리를 결정하고 개별적으로 측정된 지점에서 생성된 이미지를 생성하는 장치입니다.

ToF 카메라의 응용 분야에는 레이저 기반 스캐너가 없는 LiDAR 이미징 시스템, 동작 감지 및 추적, 머신 비전 및 자율 주행을 위한 물체 감지, 지형 매핑 등이 있습니다.

그러나 이러한 측정은 어떻게 이루어졌습니까?

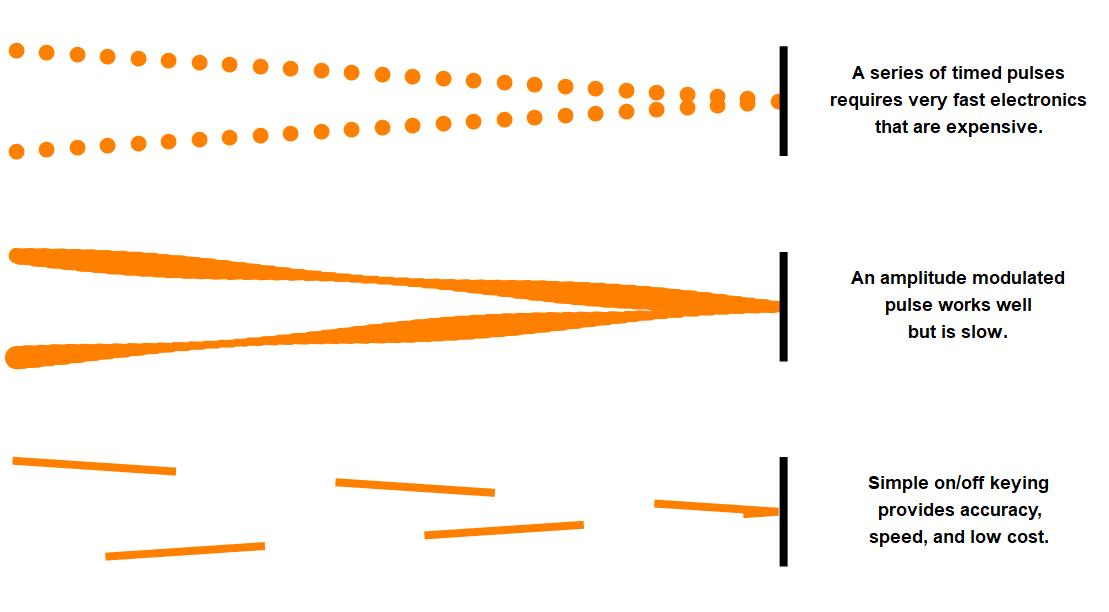

아래에는 이동 시간을 사용하여 거리를 결정하는 세 가지 방법이 나와 있습니다.

이미지 상단에서 첫 번째 방법인 펄스를 보내고 반사 후 돌아올 때까지 시간 간격을 측정하는 것을 볼 수 있습니다.

이미지 중간은 광원의 진폭을 변조하고 반사파의 위상 변화를 기록할 수 있는 두 번째 방법을 보여줍니다.

이미지 하단은 50% 듀티 사이클 구형파를 전송하고 특정 간격에 도달하는 반환된 빛의 양을 기록하는 세 번째 방법을 나타냅니다.

빛과 전파는 거의 300,000,000,000mm/s의 속도로 이동하며, 이는 파동이 1mm를 이동하는 데 ~3.3ps(그리고 다시 돌아오는 데 3.3ps)로 변환됩니다. 즉, 현재 있는 방의 모든 물체를 이미지화할 수 있는 장치를 원하고 ~ 1mm 해상도를 원할 경우 타이밍 전자 장치에 피코초 해상도가 필요합니다. 이는 수백 GHz의 클록 속도로 변환됩니다.

해당 주파수에서 작동하는 전자 회로를 설계하는 것은 쉽지도 않고 경제적이지도 않습니다. 따라서 설계자는 소비자 공간에 저렴한 장치를 제공하려면 더 낮은 주파수에서 작동하는 방법을 찾아야 했습니다.

합리적인 sub-GHz 주파수로 작업하면서 밀리미터 수준의 정밀도를 달성하기 위한 두 가지 일반적인 방법이 있습니다.

<울>아래 섹션에서 이 두 가지 방법을 더 자세히 살펴보겠습니다.

최대 길이가 15m인 작은 사무실이나 큰 거실을 매핑하려고 한다고 가정해 보겠습니다. 해당 길이에 대한 적절한 작동 주파수를 결정하려면 $$c=\lambda \cdot f$$를 사용하십시오. 여기서 c는 광속입니다(c=3x10 8 m/s), λ는 하나의 파장(λ=15m)이고 ƒ는 주파수입니다. 이 예에서 ƒ=20MHz는 비교적 작업하기 쉬운 주파수입니다.

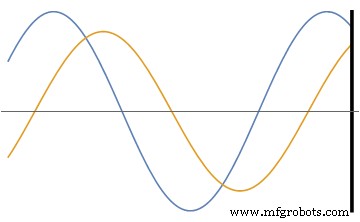

이 모든 것은 밝은 빛이 20MHz 정현파 신호로 변조된 출력을 가질 때 시작됩니다. 광파는 결국 물체나 벽에 도달하고 반사되어 방향이 바뀝니다. 원래 변조된 빛의 더 희미한 버전이 수신기로 돌아갑니다. 물체가 정확히 15미터 떨어진 정수배가 아닌 한 위상은 어느 정도 이동합니다.

위상 변이를 사용하여 파동이 이동한 거리를 계산할 수 있습니다.

위상각을 정확하게 측정할 수 있다면 반사 물체가 센서/수신기에서 떨어져 있는 거리를 정확하게 결정할 수 있습니다.

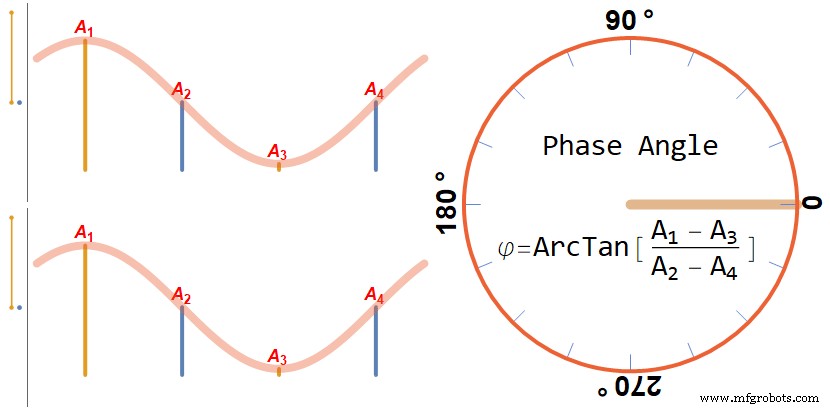

그렇다면 사인파의 위상각을 빠르게 측정하는 방법은 무엇입니까? 여기에는 동일한 간격의 4개 지점(즉, 90° 또는 1/4 λ의 간격)에서 수신된 신호의 진폭을 측정하는 것이 포함됩니다.

아래에서 측정값과 위상각 사이의 관계를 설명하려고 했습니다. A1 간의 차이 비율 그리고 A3 그리고 A2의 차이 그리고 A4 위상각의 탄젠트와 같습니다. ArcTan은 실제로 적절한 사분면을 매핑하고 A2 =A4 및 A1>A3 또는 A3>A1 0° 또는 180°로 각각.

위의 그림에서 그래프의 맨 왼쪽에는 A1을 뺀 결과를 보여주는 두 개의 수직 숫자 선이 있습니다. 그리고 A3 (진한 노란색으로 표시) 및 A2 그리고 A4 (파란색으로 표시). 측정값은 가운데 정현파 그래프에서 수직선으로 표시됩니다.

이 그래픽은 반사를 고려하지 않습니다(모든 것을 180° 효과적으로 이동함).

예제로 돌아가서 대상까지의 거리는 다음 방정식으로 결정됩니다.

여기서 c는 빛의 속도, phi(φ)는 위상각(라디안), ƒ는 변조 주파수입니다.

광자의 실제 비행 시간을 측정하려면 333GHz 전자 장치가 필요합니다. 이 방법은 변조 주파수의 최대 4배를 필요로 하며, 이 경우에는 4x20MHz=80MHz입니다. 이것은 자원의 경이적인 감소입니다. 그러나 일부 영리한 엔지니어가 최대 주파수를 훨씬 더 줄이는 방법을 찾았다는 사실을 알게 되어 기쁩니다.

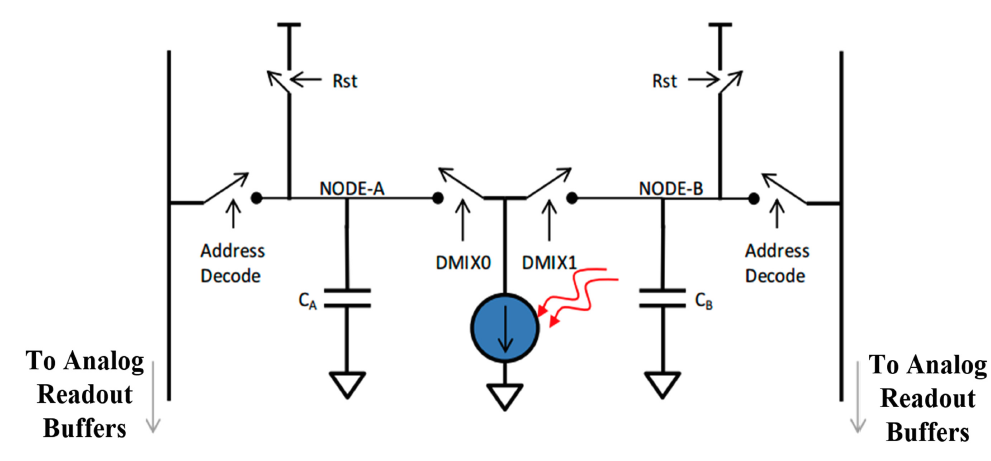

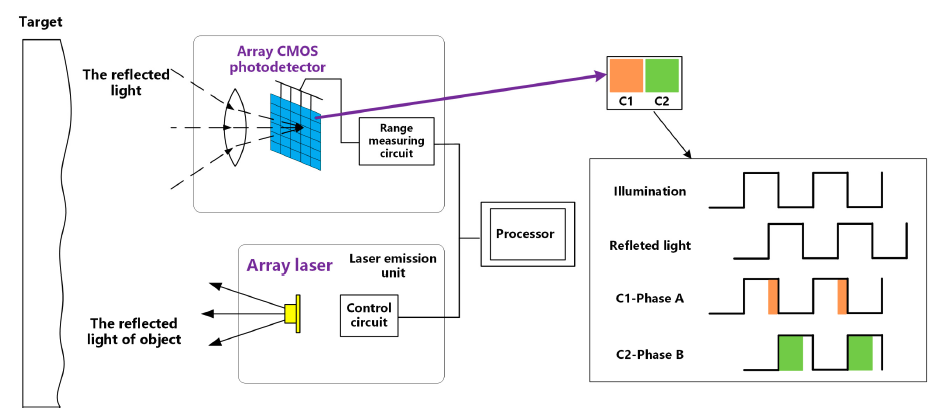

다음 측정 상황에는 스트로보스코프 광원과 픽셀당 두 개의 커패시터가 있는 CMOS 이미징 센서가 포함됩니다.

클록 소스는 50% 듀티 사이클 구형파를 생성하고 이 구형파는 밝은 스트로빙 광원과 각 픽셀 내부의 전하 저장 커패시터에 대한 연결을 제어합니다.

이러한 시스템의 예는 아래 이미지에 나와 있습니다.

빛은 소스를 떠나 물체에서 반사되어 커패시터 CA에 전하로 기록될 픽셀에 부딪힙니다. 또는 CB 위에 표시된. 커패시터는 동일한 클럭 소스를 사용하여 조명 소스와 동일한 주파수에서 픽셀에 교대로 연결됩니다.

이 영리한 배열은 커패시터의 차동 전하가 위상 오프셋과 직접 관련됨을 의미합니다. 그리고 위상은 파장과 대상과의 거리에 따라 결정됩니다.

커패시터를 채우는 데 필요한 만큼의 주기 동안 피사체를 조명할 수 있습니다. 거리가 일정한 한 충전 비율은 동일하게 유지됩니다.

이 방법은 얼마나 잘 작동합니까? 예상보다 좋습니다.

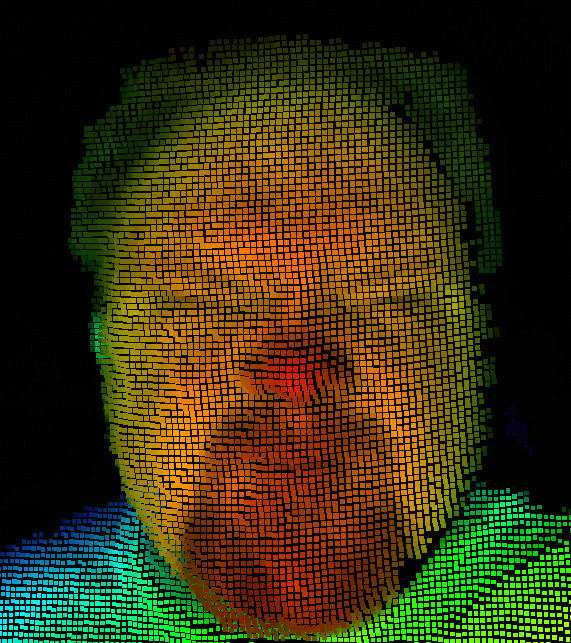

AAC에 제공된 센서는 함께 제공되는 소프트웨어와 결합되어 최대 45fps를 기록할 수 있습니다. 낮은 재생 빈도에서 시스템은 셔츠의 주름을 쉽게 이미지화할 수 있습니다.

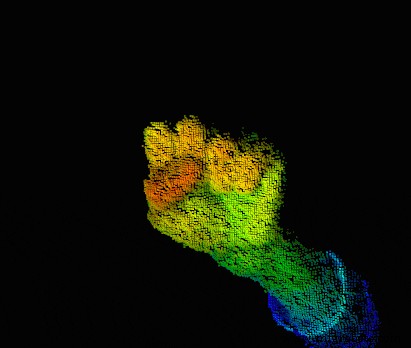

깊이 전용 데이터는 그 자체로 시각화하기 어렵습니다. 따라서 깊이 이미지는 종종 사진과 결합되거나 장면을 더 쉽게 시각화할 수 있도록 가색을 사용하여 표시됩니다.

<시간 />

비행 시간 센서는 영리한 물리학과 엔지니어링을 결합할 때 환경의 3D 지도를 만드는 것을 포함하여 다양한 응용 분야에서 활용할 수 있습니다.

작업에 3D 카메라를 사용한 적이 있습니까? 비행 시간 센서 사용의 설계 제약에 대해 무엇을 말할 수 있습니까? 아래 댓글에서 경험을 공유하세요.

산업기술

3D 펜으로 3D 아트를 시작하는 방법이 궁금하십니까? 이 장치를 사용하면 플라스틱 필라멘트를 사용하여 다양한 모양의 모델을 만들 수 있습니다. 당신이 고려해야 할 것은 당신이 가지고있는 3D 펜의 유형입니다. 뜨겁거나 차가운 3D 펜인가요? 3D 펜은 대부분의 3D 인쇄 장치에 사용되는 것과 동일한 기술을 사용합니다. 삽입한 플라스틱 필라멘트를 가열하여 노즐을 통해 압출합니다. 요령은 필라멘트가 식으면서 원하는 모양을 만드는 것입니다. 거의 즉시 건조되기 때문에 한 번 완성하면 형태가 무너질 염려가 없습니다. 펜의 필라

인쇄 회로 기판(PCB)은 한 층에서 여러 층의 유전체 및 전도성 물질로 구성됩니다. 보드에 결합되면 이 레이어는 알람 시계, 주방 가전, 책상 용품, 컴퓨터 및 모바일 장치와 같은 광범위한 가전 제품에 전력을 공급하는 회로를 운반합니다. PCB는 또한 의료 기기, 정부 컴퓨터 및 저장 시스템, 항공우주 장비뿐만 아니라 광범위한 산업 도구 및 기계에 사용됩니다. 특정 보드의 레이어 수와 치수는 PCB의 전력 분배를 결정합니다. 다층 PCB란 무엇입니까? PCB 레이어는 인쇄 회로 기판의 전력과 용량을 결정하는 요소입니다. 사람