임베디드

벤치마킹 조직 ML Commons는 MLPerf 추론 점수의 새로운 라운드를 발표했습니다. 이 최신 라운드는 더 쉽게 비교할 수 있도록 장치 클래스로 구분됩니다. 결과는 또한 상업적으로 배포되지만 여전히 최첨단으로 간주되는 다양한 워크로드를 나타내기 위한 다양한 새로운 AI 모델을 특징으로 합니다.

Nvidia 가속 시스템은 전체 제출물의 약 85%를 차지하여 그들이 입력한 모든 카테고리에서 우승했습니다. 그러나 모바일 또는 노트북 클래스에는 Nvidia 제출이 없었습니다(Nvidia는 AI 가속 제품이 있는 이러한 시장에 존재하지 않습니다). 또한 스타트업에서 여러 흥미로운 제출물이 있었고, 전반적으로 더 쉽게 비교할 수 있도록 여러 열에 숫자를 사용하는 경향이 더 컸습니다.

지난 라운드의 변경 사항

이번 라운드 결과의 첫 번째 주요 변경 사항은 시스템이 데이터 센터, 에지, 모바일 및 노트북의 클래스로 분리되었다는 것입니다. 휴대전화와 노트북은 매우 구체적인 폼 팩터와 성능 프로필을 가지고 있어 더 넓은 범위의 목록과 쉽게 구분할 수 있습니다.

ML Commons의 전무이사인 David Kanter는 EE Times에 "노트북에 대해 이야기한다면 Windows를 실행하고 있을 것이고, 스마트폰에 대해 이야기한다면 iOS 또는 Android를 실행하고 있을 것입니다."라고 말했습니다.> . "이 결과를 더 큰 추론 점수 풀에서 분리하면 상황을 더 명확하게 만드는 데 매우 도움이 됩니다."

이 두 번째 추론 점수에 대한 벤치마크도 최신 사용 사례를 나타내는 AI 모델을 포함하도록 수정되었습니다. 이전 라운드에서는 비전 및 이미지 처리 모델에 중점을 두었지만 이번에는 데이터 센터 및 에지 클래스에 추천 모델 DLRM, MRI 스캔에서 종양을 찾는 데 사용되는 의료 영상 모델 3D-UNet, 음성-텍스트 모델 RNN-이 포함됩니다. T 및 자연어 처리(NLP) 모델 BERT.

Kanter는 "[모델 선택]은 고객 입력에 의해 주도되지만 학생들이 스스로 테스트를 설정하도록 하는 함정에 빠지고 싶지 않습니다."라고 Kanter는 설명하면서 목표는 생산 중인 최첨단 모델을 식별하는 것이라고 설명했습니다. 연구 단계에서만이 아니다. "DLRM과 3D-UNet은 우리 자문 위원회, 의료계 사람들, 대규모로 추천하는 사람들에 의해 주도된 매우 [선택] 정보였습니다. 이러한 종류의 정보에 입각한 워크로드 구성은 매우 가치가 있습니다."

모바일 및 노트북 클래스는 이미지 분류에 MobileNetEdge, 객체 감지에 SSD-MobileNetv2, 이미지 분할에 Deeplabv3, NLP에 Mobile BERT를 사용합니다.

전반적으로 실제 배포를 반영하기 위해 정확도 목표도 높아졌습니다.

아래 분석은 공정한 비교를 위해 "닫힌" 부분만 참조합니다.

데이터 센터 결과

예상대로 데이터 센터 클래스의 대부분의 제출은 Nvidia GPU 가속기를 사용했습니다. 나머지는 몇 가지 예외를 제외하고 AI 처리를 위해 Intel CPU를 사용했습니다(아래 참조). 이번에는 TPU에 대한 Google의 제출물이 없으며 이 분야(Graphcore, Cerebras, Groq 등)에서 자리를 잡고 있는 신생 기업 커뮤니티의 누구도 제출하지 않았습니다.

Paresh Kharya는 "ResNet이라는 기본 컴퓨터 비전 모델과 고급 추천 시스템 모델에서 CPU에 대한 [Nvidia의] 성능 우위가 약 6X에서 30X로 증가했습니다. Nvidia A100은 [Intel의] Cooper Lake CPU보다 237배 빠릅니다."라고 말했습니다. , Nvidia의 제품 관리 및 마케팅 수석 이사입니다. "단일 DGX-A100은 추천 시스템에서 1000개의 CPU 서버와 동일한 성능을 제공하며 고객에게 놀라운 가치를 제공합니다."

Mipsology는 이 부문에서 유일하게 상업적으로 이용 가능한 non-CPU non-GPU 진입자였습니다. 이 회사는 Xilinx FPGA(이 경우 Xilinx Alveo U250)에서 실행되는 Zebra라는 가속기 기술을 보유하고 있습니다. 그들의 기술은 서버 모드에서 초당 4096개의 ResNet 쿼리(Nvidia T4의 경우 약 5563개) 또는 오프라인 모드에서 초당 5011개의 샘플(Nvidia T4의 경우 약 6112개)을 처리할 수 있습니다.

대만 회사인 Neuchips는 연구, 개발 또는 내부 범주에 점수를 제출했습니다. 이는 사용된 장치가 상업적으로 이용 가능하지 않으며 최소 6개월 이상 사용되지 않을 것임을 의미합니다. RecAccel은 이 벤치마크에서 사용된 권장 모델인 DLRM을 가속화하도록 특별히 설계되었습니다. AI 추론을 위해 Intel Stratix FPGA에서 실행되는 대규모 병렬 설계를 사용합니다. DRLM 범주의 결과는 Intel Cooper Lake CPU와 비슷하거나 나빴고 Nvidia와 일치하지 않았습니다.

가장자리 결과

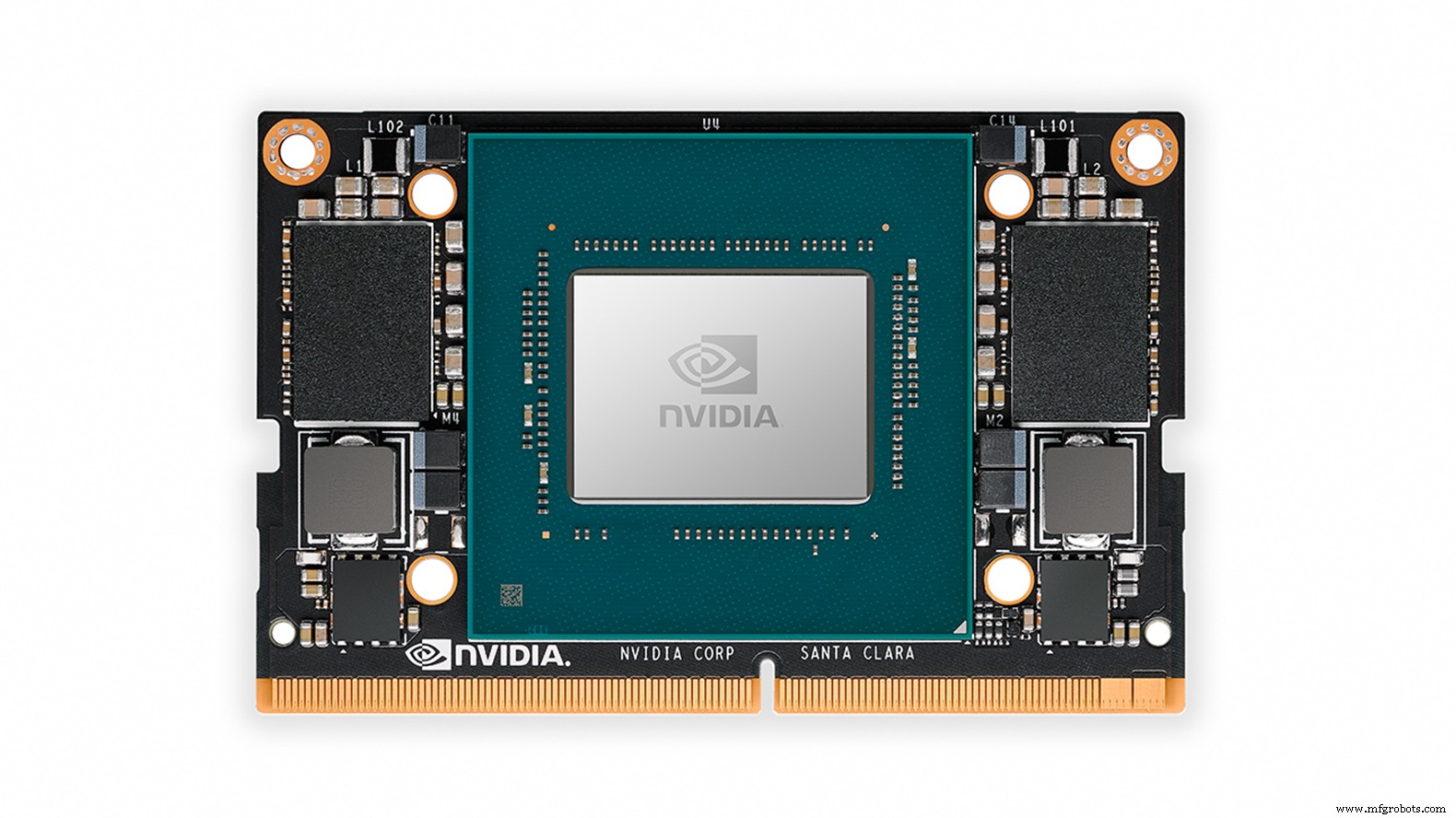

에지 카테고리는 Nvidia의 A100, T4, AGX Xavier 및 Xavier NX에 의해 가속화된 점수가 지배했습니다.

Centaur Technology는 자체 x86 마이크로아키텍처 기반 Centaur의 서버 프로세서와 별도의 사내 AI 가속기를 보조 프로세서로 사용하는 상용 참조 설계 시스템의 결과를 얻었습니다. Centaur에 따르면 이 참조 디자인은 온프레미스 또는 개인 데이터 센터 애플리케이션을 위한 서버급 시스템이며 비용 및 폼 팩터(전력 소비 또는 최고 성능이 아닌)에 최적화되어 있습니다.

ResNet 이미지 분류(단일 스트림 대기 시간)에서 Centaur의 시스템은 Tesla T4가 장착된 서버 시스템에 대한 Nvidia의 자체 제출보다 빠릅니다. 그러나 T4는 초당 처리되는 ResNet 오프라인 샘플에서 Centaur의 설계를 능가했습니다. 그러나 Centaur는 Nvidia의 2가지 임베디드 에지 모듈인 Xavier NX와 AGX Xavier 사이 어딘가에 있는 물체 감지에서 그다지 좋지 않았습니다.

ML 하드웨어 및 소프트웨어 시스템을 객관적으로 평가하는 것을 전문으로 하는 영국 엔지니어링 컨설팅 회사인 dividiti는 Fireflys 및 Raspberry Pis에서 Nvidia AGX Xavier에 이르는 시스템에 대한 일련의 점수를 제출했습니다. Raspberry Pi 항목에 대해 동일한 점수가 실제로 다른 운영 체제를 사용하고 있습니다(32비트 Debian 대 64비트 Ubuntu – Ubuntu가 약 20% 더 빠름). 회사의 결과는 Nvidia가 AGX Xavier의 GPU와 2개의 온칩 딥 러닝 가속기를 ResNet Offline 및 Multistream 점수에 사용했기 때문에 AGX Xavier에 대한 Nvidia 자체의 결과와 달랐습니다. 여기서 dividiti는 GPU만 사용했습니다.

dividiti 대변인도 EE Times에 말했습니다. 회사는 이전 추론 라운드에서 Nvidia의 점수를 "다소 또는 적게" 재현했지만, 최신 결과는 제출 마감 몇 분 전에만 발견된 테스트 장치에 성능 회귀를 도입했습니다(이 실수를 수정하면 나중에 10-20%). 이것은 결과에 대한 하드웨어/소프트웨어 조합의 중요성을 설명하는 역할을 합니다.

에지 카테고리는 Jetson Xavier NX(이미지:Nvidia)를 포함한 Nvidia GPU에 의해 가속화된 결과에 의해 지배되었습니다.

이 카테고리의 새로운 항목에는 연구, 개발 또는 내부 카테고리의 IVA Technologies 및 Mobilint가 포함됩니다.

러시아 IT 장비 설계 및 제조업체인 IVA Technologies는 컨볼루션, 3D 컨볼루션 및 LSTM 모델을 지원하는 AI 가속기 칩을 개발하고 있습니다. 회사는 FPGA에 구현된 가속기 ASIC의 프로토타입일 수 있는 "FPGA"라는 점수를 제출했습니다. ResNet 단일 스트림 대기 시간은 12.23ms로 Xavier NX보다 약 4배 느리고 Xavier NX의 10분의 1 미만인 초당 89개의 오프라인 샘플을 처리했습니다. 그러나 Edge 카테고리는 광범위하고 디자인에 대해 많이 알려져 있지 않습니다. Xavier NX보다 작은 장치를 위한 것일 수 있습니다.

한국의 AI 가속기 ASIC 스타트업인 Mobilint는 EE Times에 Mobilint Edge 디자인에 대한 점수를 제출했습니다. 용의자는 Xilinx Alveo U250 FPGA 카드의 프로토타입으로 구현되었습니다. ResNet에서 대기 시간은 37.46ms로 IVA Technologies의 설계보다 훨씬 길었지만 초당 더 많은 오프라인 샘플을 처리했습니다(107). 회사는 물체 감지 점수도 제출했습니다.

IVA Technologies나 Mobilint 모두 획기적인 점수를 내지는 못했지만, 동반 소프트웨어 스택이 준비되었음을 증명하기 때문에 프로토타입을 벤치마킹하는 것은 확실히 가치가 있습니다.

모바일 검색결과

새로운 모바일 SoC 카테고리에는 명확한 승자가 없는 상당히 잘 어울리는 3개의 제출이 있었습니다.

MediaTek은 Dimensity 820(Xiaomi Redmi 10X 5G 스마트폰)에 대한 점수를 제출했습니다. 이 장치는 카메라/이미징 기능에 최적화된 FP16 및 INT16 지원 가속기인 MediaTek의 자체 AI 처리 장치(APU) 3.0을 사용합니다. SoC에는 5코어 GPU도 있습니다.

Qualcomm Snapdragon 865+는 Adreno 650 GPU와 함께 15 TOPS에서 작동하는 AI 가속을 위해 설계된 회사의 Hexagon 698 프로세서를 사용합니다. 벤치마크는 Asus ROG Phone 3에서 실행되었습니다.

Samsung의 Exynos 990은 Galaxy Note 20 Ultra의 일부로 벤치마킹되었습니다. 이 장치에는 다양한 Arm CPU 코어와 함께 듀얼 코어 NPU(신경 처리 장치) 및 Arm Mali-G77 GPU가 포함되어 있습니다.

삼성의 엑시노스 990은 이미지 분류와 NLP에서 최고였다. MediaTek Dimensity 820은 이미지 분류에서 매우 가까웠지만 NLP에서는 삼성이 더 명확하게 앞서 있었습니다. MediaTek은 Qualcomm Snapdragon 865+가 2위를 차지하면서 물체 감지 분야에서 확실한 선두를 달리고 있습니다. MediaTek은 또한 Qualcomm을 근소한 차이로 앞서는 이미지 세분화 벤치마크에서 우승했습니다.

노트북 결과

노트북 범주에는 곧 출시될 Intel Xe-LP GPU를 가속기로 사용하는 Intel 참조 설계라는 단 하나의 항목만 있었습니다. Xe-LP는 데이터 센터 AI 가속 및 HPC를 위한 Xe-HP 및 Xe-HPC의 저전력 버전입니다. 더 큰 기기는 모두 벤치마킹되지 않았습니다.

이 수업에는 항목이 하나밖에 없었기 때문에 Xe-LP의 결과를 해석하기가 까다롭습니다. 다만, 노트북 카테고리는 모바일 카테고리와 동일한 AI 모델을 사용하고 있어 다소의 비교는 불가피하다. 모바일 SoC에 비해 Xe-LP의 가장 큰 장점은 처리량(초당 프레임 수)에서 모바일 승자를 2.5배 능가하는 이미지 분할(DeeplabV3)에 있었습니다. 가장 약한 성능은 처리량(초당 프레임 수) 면에서 모바일 승자보다 1.15배 더 높은 객체 감지(SSD – MobileNetv2)였습니다.

향후 벤치마크

앞으로 Kanter는 조직이 신생 기업과 소규모 회사가 결과를 제출하도록 장려하기 위해 최선을 다했다고 말하면서 향후 벤치마크 라운드에 더 많은 비 Nvidia 및 비 Intel CPU 항목이 포함될 것으로 기대하고 있습니다.

"우리는 원하는 네트워크를 제출할 수 있는 개방형 부서가 있습니다."라고 그는 말했습니다. "그의 좋은 점 중 하나는 고객이 내가 X를 원한다고 말하고 그에 대한 모든 지원을 수행하면 실행 중인 것을 볼 수 있도록 코드를 삽입할 수 있는 한 X를 사용할 수 있다는 것입니다. "

기업은 엔지니어링 노력을 줄이기 위해 하나의 AI 모델에 대한 결과를 제출할 수 있으며 자체 모델을 공개 범주에 제출할 수도 있습니다.

Kanter는 또한 다음 라운드 점수에 전력 측정 차원을 도입하는 것이 조직의 의도라고 언급했습니다. 작업이 이미 진행 중입니다.

Kanter는 "사람들을 참여시키고 싶은 것 중 하나는 전력 측정 인프라 구축을 돕는 것입니다. 이러한 측정을 위한 도구를 구축하는 데 도움이 됩니다."라고 말했습니다.

MLPerf 추론 결과의 전체 목록은 여기에서 자세히 확인할 수 있습니다.

>> 이 기사는 원래 다음 날짜에 게시되었습니다. 자매 사이트인 EE Times.

임베디드

데이터 과학자는 데이터 과학 프로젝트의 성공에 매우 중요합니다. 하지만, 그들은 혼자 할 수 없습니다. 그들은 다른 기술과 자동화 솔루션의 도움이 필요합니다. 데이터, 기름 그것은 현대 기계의 톱니에 기름을 바르는 것입니다. 하지만 문제가 있습니다. 조직은 이 새로운 힘에서 비즈니스 통찰력을 얻기 위해 고군분투하고 있습니다. 공급 부족 시장에서 많은 기업 고객이 매우 큰 데이터 과학 팀을 구축하려고 합니다. 일부는 폭발적인 데이터를 처리하기 위해 수백 명을 고용하려고 합니다. 고객 입력에서 IoT 장치에 이르는 다양한 소스와

빅 데이터가 미래 기술 발전의 주요 부분임에는 의심의 여지가 없습니다. 그러나 머신 러닝(ML)과 인공 지능(A.I)은 모두 이 개발에서 중요한 역할을 합니다. 빅 데이터는 재료, 머신 러닝은 방법, 인공 지능은 결과의 세 가지 관계를 간략하게 설명합니다. 머신 러닝이란 무엇입니까? 기계 학습(ML)은 인공 지능(A.I) 유형 중 하나로서 명시적으로 프로그래밍하지 않고도 시스템이 경험을 통해 자동으로 학습, 적응 및 개선할 수 있는 능력을 시스템에 부여하는 방식으로 알고리즘을 작성합니다. .머신 러닝 알고리즘은 학습 대상 데이터