사물 인터넷 기술

누구에게나 "공정성"에 대해 가르치는 것은 칭찬할만한 목표입니다.

인간으로서 우리는 공정한 것에 대해 반드시 동의하지 않을 수도 있습니다. 때로는 컨텍스트에 따라 다릅니다. 가정과 학교에서 아이들에게 공정하도록 가르치는 것은 기본이지만 말처럼 쉽지 않습니다. 이를 염두에 두고 우리는 한 사회로서 인공 지능(AI) 시스템에 "공정함"의 뉘앙스를 어떻게 전달할 수 있습니까?

IBM Research의 연구원 팀이 이 수수께끼에 첫 번째 균열을 내고 있습니다. IBM은 "AI Fairness 360"이라는 개발자용 도구 키트를 출시하고 있습니다. 이러한 노력의 일환으로 IBM은 기업이 AI 기반 시스템이 어떻게 작동하는지 테스트하고 검증하는 데 사용할 수 있는 새로운 "클라우드 기반, 편향 감지 및 완화 서비스"를 기업에 제공하고 있습니다.

IBM Research의 펠로우인 Saska Mojsilovic은 EE Times와의 전화 인터뷰에서 과학자들과 AI 실무자들이 AI의 정확성에 너무 집중해 왔다고 말했습니다. 일반적으로 사람들이 AI에 대해 묻는 첫 번째 질문은 "기계가 인간을 이길 수 있습니까?"입니다.

그러나 공정성은 어떻습니까? 그녀는 AI의 공정성 무효가 예를 들어 의료나 자율주행 차량에서 치명적인 결과를 초래할 가능성이 있다고 말했습니다.

머신을 훈련하는 데 사용되는 데이터 세트가 편향된 경우 어떻게 됩니까? AI가 어떻게 결정을 내렸는지 설명할 수 없다면 어떻게 "옳음"을 확인할 수 있을까요? AI가 AI 처리 중에 데이터가 어떻게든 조작되었는지 밝힐 수 있습니까? AI는 사전 및 사후 처리를 포함하여 데이터가 공격을 받거나 손상된 적이 없다고 보장할 수 있습니까?

요컨대, 내성적인 AI 같은 것이 있습니까? 간단한 대답:아니요.

AI 사용자, 개발자 및 실무자에게 투명하지 않고 AI 시스템은 사회로부터 신뢰를 얻을 수 없다고 Mojsilovic은 말했습니다.

공정성 파괴

더 큰 문제는 기계에게 공정함이 무엇인지 가르치는 방법입니다. Mojsilovic은 "우리는 과학자이기 때문에 가장 먼저 '공정성'을 분해하는 작업을 수행했습니다. 우리는 이를 해결해야 했습니다."라고 말했습니다. 그들은 AI 구현에서 실행되는 메트릭, 알고리즘 및 편향 측면에서 공정성을 분류했습니다.

IBM의 연구 과학자인 Kush Varshney는 팀이 AI 알고리즘과 AI 의사 결정에서 편견과 공정성을 살펴보았다고 설명했습니다. “개인에 대한 공정성이 있고 집단에 대한 공정성이 있습니다. 우리는 성별에서 인종에 이르기까지 그룹의 다양한 속성을 살펴보았습니다. 법률 및 규제 문제도 고려됩니다.” 결국 팀은 데이터 세트, AI 모델 및 알고리즘에서 편향을 찾기 위해 30개의 서로 다른 메트릭을 측정했습니다.

이러한 결과는 IBM이 이번 주에 출시한 AI Fairness 360 도구 상자에 통합되었습니다. 회사는 이를 "데이터 세트 및 머신 러닝 모델에서 원치 않는 편향을 확인하기 위한 메트릭의 포괄적인 오픈 소스 툴킷"이라고 설명했습니다.

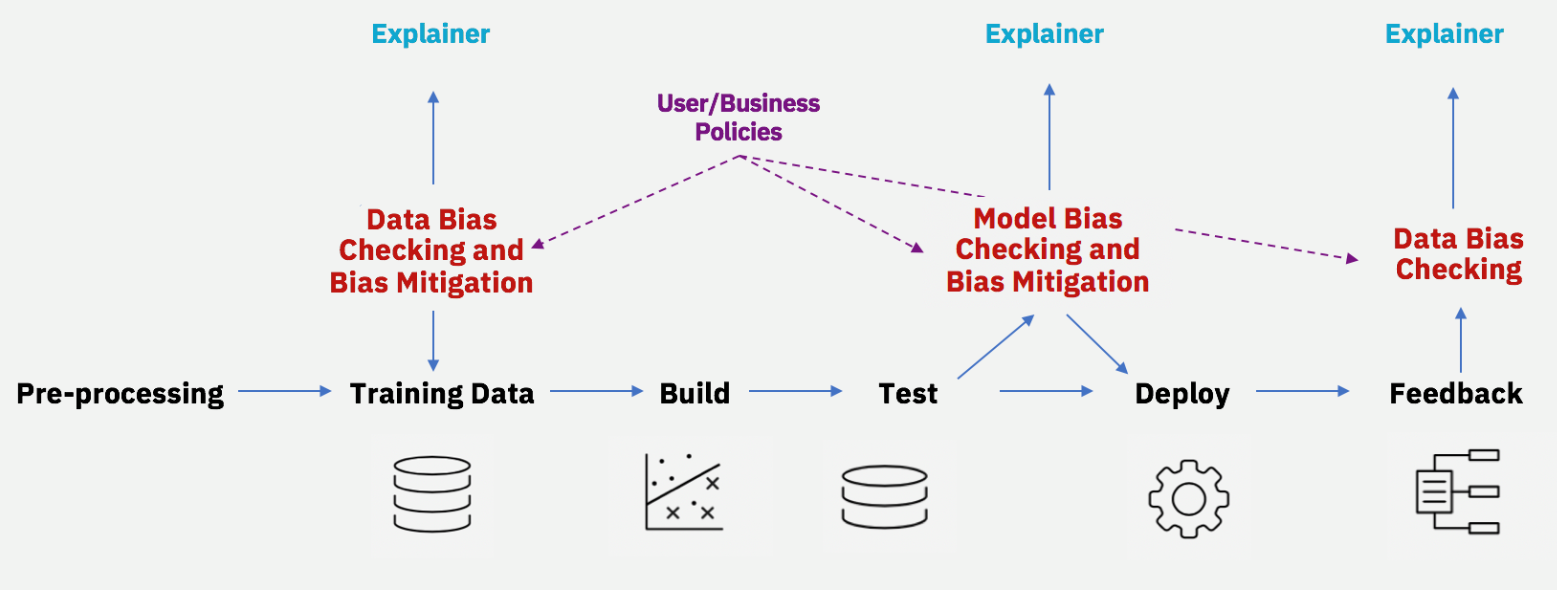

AI 수명 주기 전반에 걸친 편향 완화(출처:IBM)

많은 과학자들이 이미 AI 알고리즘에서 차별을 발견하기 위해 노력하고 있지만 Mojsilovic은 IBM의 접근 방식은 편향을 찾는 알고리즘뿐만 아니라 편향 제거 도구를 포함한다는 점에서 다릅니다.

기본적인 수준에서 다음과 같이 질문해야 합니다. 컴퓨터 과학자 - 공정성을 정의하는가? 이것은 일반적으로 사회 과학자에게 할당되는 작업입니까? 이러한 부조화를 인식한 IBM은 Mojsilovic과 Varshney 모두 진공 상태에서 작업하지 않는다는 점을 분명히 했습니다. 그들은 많은 학자와 기관을 데려왔습니다. Varshney는 카네기 국제 문제 윤리 위원회가 후원하는 Uehiro-Carnegie-Oxford 윤리 회의에 참가했습니다. Mojsilovic은 UC Berkeley Law School이 후원하는 캘리포니아 버클리 AI 워크숍에 참여했습니다.

알고리즘은 중립적입니까?

사회과학자들은 오래전부터 AI 편향 문제를 지적해 왔습니다.

University of Wisconsin-Madison의 저널리즘 및 매스커뮤니케이션학부 김영미 교수는 “AI 차별(또는 AI 편견)은 기존의 불평등한 사회 질서와 편견(예:성별, 인종, 나이, 사회/경제적 지위 등).” 예는 샘플링 오류(예:샘플링 방법의 부적절하거나 어려움으로 인한 특정 인구 통계의 과소 표현)에서 기계 훈련(모델링)의 인간 편향에 이르기까지 다양합니다. Kim은 정치 광고 알고리즘과 같은 디자인이나 모델링에서 '전략적 결정'에도 AI 편향이 존재한다고 주장했습니다.

김 교수는 최근 "알고리즘 기회:디지털 광고와 정치적 참여의 불평등"이라는 제목의 연구에서 알고리즘 기반 의사결정에서 불평등이 어떻게 강화될 수 있는지 보여주었습니다.

기술 커뮤니티는 "알고리즘은 중립적"이거나 "교육"(훈련)될 수 있다고 주장할 수 있습니다. 김 교수는 “알고리즘 개발의 어느 단계에서든 편향이 들어간다는 사실을 인정하지 않는다”고 지적했다.

사물 인터넷 기술

머신 러닝은 인공 지능의 일부이며 기계가 직접 프로그래밍하지 않고 실제 데이터에서 학습하는 것으로 구성됩니다. 이 게시물에서는 이러한 알고리즘이 업계에 가져올 수 있는 이점을 사용하는 방법을 살펴보겠습니다. 머신러닝 머신 러닝은 인공 지능의 한 분야입니다. (AI) 기계가 알고리즘을 통해 학습할 수 있도록 합니다. 이러한 알고리즘은 모델이 생성되는 실제 데이터에서 학습합니다. 이 모델을 사용하면 새 데이터가 어떤 클래스 또는 유형인지 예측할 수 있습니다. 기계 학습 내에는 지도 학습과 비지도 학습의 두 가지 유형이 있습니다

지금까지 모든 사람들은 머신 러닝과 머신 러닝이 모든 것을 어떻게 변화시킬지에 대해 들었습니다. 하지만 모든 것을 어떻게 바꿔야 할지 아는 사람은 거의 없습니다. 이 블로그의 단계를 시도하거나 이에 대해 읽을 때 PLCnext 컨트롤러로 변경을 시작하는 방법을 이해하는 데 도움이 되기를 바랍니다. 이 블로그에서는 첫 번째 ML 모델을 교육하고 ONNX 표준으로 변환하고 PLCnext 컨트롤러에서 모델을 추론하는 방법에 대해 설명합니다. 진행하지 않고 압도적인 일을 만들기 위해 저는 유명한 Iris 데이터 세트를 사용하여 모델을 구축