임베디드

엣지에서 AI가 부상하면서 메모리 시스템에 대한 완전히 새로운 요구 사항이 등장했습니다. 오늘날의 메모리 기술은 이 도전적인 새로운 애플리케이션의 엄격한 요구 사항을 충족할 수 있으며 신흥 메모리 기술은 장기적으로 에지 AI에 무엇을 약속합니까?

가장 먼저 깨달아야 할 것은 표준 "에지 AI" 애플리케이션이 없다는 것입니다. 가장 광범위한 해석의 에지는 클라우드 외부의 모든 AI 지원 전자 시스템을 포괄합니다. 여기에는 일반적으로 엔터프라이즈 데이터 센터와 온프레미스 서버를 포괄하는 "니어 에지"가 포함될 수 있습니다.

더 나아가 자율 주행을 위한 컴퓨터 비전과 같은 애플리케이션이 있습니다. 제조용 게이트웨이 장비는 생산 라인에서 제품의 결함을 확인하기 위해 AI 추론을 수행합니다. 전신주에 있는 5G "엣지 박스"는 교통 관리와 같은 스마트 시티 애플리케이션을 위한 비디오 스트림을 분석합니다. 그리고 5G 인프라는 복잡하지만 효율적인 빔 형성 알고리즘을 위해 엣지에서 AI를 사용합니다.

"먼 에지"에서 AI는 다른 게이트웨이 장치로 결과를 보내기 전에 센서 융합을 수행하는 공장의 기기 및 IoT 센서 노드의 음성 제어(Snapchat 필터를 생각해 보세요)와 같은 휴대전화와 같은 장치에서 지원됩니다.

신경망 가중치, 모델 코드, 입력 데이터 및 중간 활성화를 저장하는 엣지 AI 시스템에서 메모리의 역할은 대부분의 AI 애플리케이션에서 동일합니다. 효율성을 유지하려면 AI 컴퓨팅 용량을 최대화하기 위해 워크로드를 가속화해야 하므로 용량 및 대역폭에 대한 요구가 일반적으로 높습니다. 그러나 애플리케이션별 요구 사항은 많고 다양하며 크기, 전력 소비, 저전압 작동, 안정성, 열/냉각 고려 사항 및 비용이 포함될 수 있습니다.

에지 데이터 센터

에지 데이터 센터는 핵심 에지 시장입니다. 사용 사례는 개인 정보 보호로 인해 클라우드에 업로드할 수 없는 의료 영상, 연구 및 복잡한 금융 알고리즘에 이르기까지 다양합니다. 다른 하나는 대기 시간이 이를 방지하는 자율 주행 차량입니다.

이러한 시스템은 다른 응용 프로그램의 서버에서 볼 수 있는 동일한 메모리를 사용합니다.

메모리 제품 설계자이자 개발자인 Smart Modular Technologies의 솔루션 아키텍트인 Pekon Gupta는 “AI 알고리즘이 개발되고 훈련되는 애플리케이션에서 빠른 바이트 수준의 메인 메모리를 위해 저지연 DRAM을 사용하는 것이 중요합니다. “대용량 데이터 세트에는 고용량 RDIMM 또는 LRDIMM이 필요합니다. NVDIMM은 시스템 가속에 필요합니다. 우리는 느린 SSD 대신 쓰기 캐싱 및 검사점에 사용합니다."

최종 사용자와 가까운 컴퓨팅 노드를 찾는 것은 통신 사업자가 취하는 접근 방식입니다.

굽타는 "우리는 이러한 [통신] 에지 서버가 복잡한 알고리즘을 더 잘 실행할 수 있도록 하는 추세를 보고 있습니다."라고 말했습니다. 따라서 "서비스 제공업체는 RDIMM, LRDIMM 및 NVDIMM과 같은 고가용성 영구 메모리와 같은 장치를 사용하여 이러한 에지 서버에 더 많은 메모리와 처리 능력을 추가하고 있습니다."

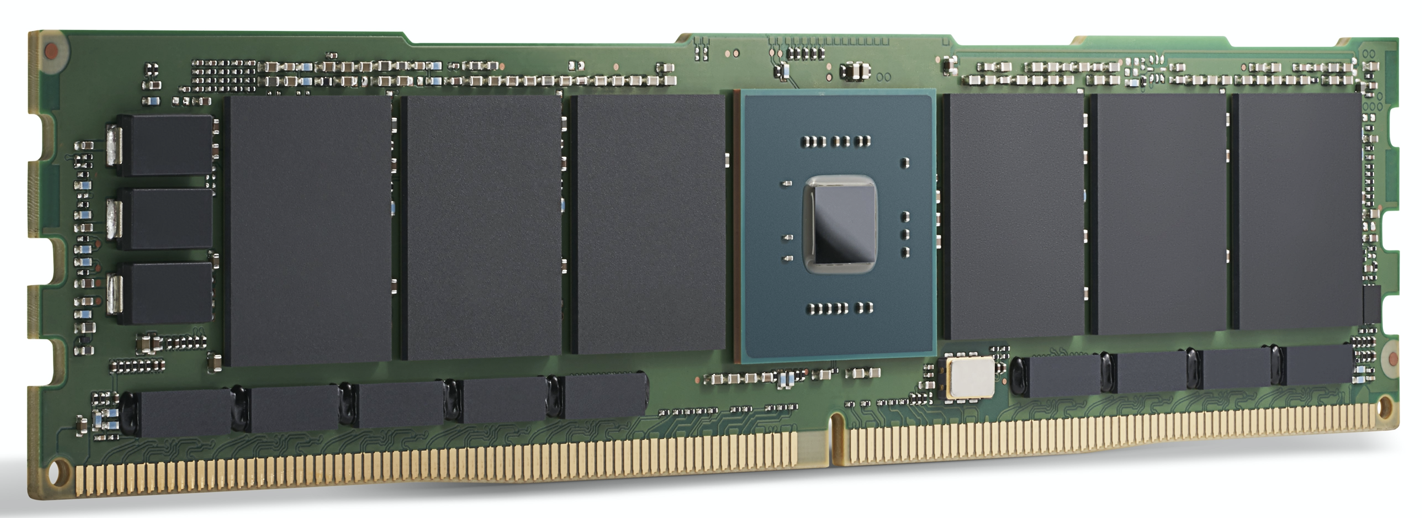

Gupta는 DRAM과 플래시 사이에 속성이 있는 회사의 3D-Xpoint 비휘발성 메모리인 Intel Optane이 서버 AI 애플리케이션을 위한 우수한 솔루션으로 보고 있습니다.

"Optane DIMM과 NVDIMM 모두 AI 가속기로 사용되고 있습니다."라고 그는 말했습니다. “NVDIMM은 AI 애플리케이션 가속화를 위해 대기 시간이 매우 짧은 계층화, 캐싱, 쓰기 버퍼링 및 메타데이터 스토리지 기능을 제공합니다. Optane 데이터 센터 DIMM은 수백 기가바이트에서 테라바이트의 영구 메모리가 DRAM과 함께 사용되는 메모리 내 데이터베이스 가속에 사용됩니다. 둘 다 AI/ML 가속 애플리케이션을 위한 영구 메모리 솔루션이지만 서로 다른 사용 사례가 있습니다.”

Intel의 Optane 제품 마케팅 이사인 Kristie Mann은 EE Times에 다음과 같이 말했습니다. Optane은 서버 AI 부문에서 애플리케이션을 확보하고 있습니다.

"우리 고객들은 이미 오늘날 AI 애플리케이션을 구동하기 위해 Optane 영구 메모리를 사용하고 있습니다."라고 그녀는 말했습니다. “이는 전자 상거래, 비디오 추천 엔진 및 실시간 재무 분석 사용을 성공적으로 지원하고 있습니다. 증가된 가용 용량으로 인해 인메모리 애플리케이션으로의 전환을 목격하고 있습니다."

DRAM의 높은 가격은 Optane을 점점 더 매력적인 대안으로 만들고 있습니다. Intel Xeon Scalable 프로세서 2개와 Optane 영구 메모리가 탑재된 서버는 데이터 사용량이 많은 애플리케이션을 위해 최대 6TB의 메모리를 보유할 수 있습니다.

"DRAM은 여전히 가장 인기가 있지만 비용 및 용량 측면에서 한계가 있습니다."라고 Mann은 말했습니다. “Optane 영구 메모리 및 Optane SSD와 같은 새로운 메모리 및 스토리지 기술은 비용, 용량 및 성능 이점으로 인해 DRAM의 대안으로 [부상하고 있습니다]. Optane SSD는 특히 강력한 캐싱 HDD 및 NAND SSD 데이터로 AI 애플리케이션 데이터를 지속적으로 공급합니다.”

Optane은 또한 오늘날 완전히 성숙하지 않거나 확장 가능하지 않은 다른 새로운 메모리에 비해 유리하다고 덧붙였습니다.

Intel Optane 200 시리즈 모듈. Intel은 Optane이 오늘날 AI 애플리케이션을 구동하는 데 이미 사용되고 있다고 말합니다. (출처:인텔)

GPU 가속

고급 에지 데이터 센터 및 에지 서버 애플리케이션의 경우 GPU와 같은 AI 컴퓨팅 가속기가 주목을 받고 있습니다. DRAM뿐만 아니라 고대역폭 GPU를 공급하도록 설계된 특수 DDR SDRAM인 GDDR과 GPU 자체와 동일한 패키지에 여러 메모리 다이를 배치하는 비교적 새로운 다이 스택 기술인 HBM이 여기에 포함됩니다.

둘 다 AI 애플리케이션에 필요한 매우 높은 메모리 대역폭을 위해 설계되었습니다.

가장 까다로운 AI 모델 교육을 위해 HBM2E는 3.6Gbps를 제공하고 460GB/s의 메모리 대역폭을 제공합니다(2개의 HBM2E 스택은 1TB/s에 가깝습니다). 이는 전력 소비가 가장 낮은 가장 작은 영역에서 사용 가능한 최고 성능 메모리 중 하나입니다. HBM은 GPU 리더인 Nvidia가 자사의 모든 데이터 센터 제품에 사용하고 있습니다.

Rambus의 IP 코어 제품 마케팅 수석 이사인 Frank Ferro는 GDDR6이 엣지에서 AI 추론 애플리케이션에도 사용된다고 말했습니다. Ferro는 GDDR6이 에지 AI 추론 시스템의 속도, 비용 및 전력 요구 사항을 충족할 수 있다고 말했습니다. 예를 들어 GDDR6은 18Gbps 및 72GB/s를 제공할 수 있습니다. 4개의 GDDR6 DRAM을 사용하면 300GB/s에 가까운 메모리 대역폭을 제공합니다.

“GDDR6은 AI 추론 및 ADAS 애플리케이션에 사용된다고 Ferro는 덧붙였습니다.

Jetson AGX Xavier에서 Jetson Nano에 이르기까지 대부분의 비데이터 센터 에지 솔루션에 대한 Nvidia의 접근 방식인 GDDR6과 LPDDR을 비교할 때 Ferro는 LPDDR이 에지 또는 엔드포인트에서 저비용 AI 추론에 적합하다는 점을 인정했습니다.

"LPDDR의 대역폭은 LPDDR4의 경우 4.2Gbps, LPDDR5의 경우 6.4Gbps로 제한됩니다."라고 그는 말했습니다. “메모리 대역폭 요구가 증가함에 따라 GDDR6을 사용하는 설계의 수가 증가하는 것을 보게 될 것입니다. 이러한 메모리 대역폭 격차는 GDDR6에 대한 수요를 높이는 데 도움이 됩니다.”

GPU와 함께 사용하도록 설계되었지만 다른 처리 가속기는 GDDR의 대역폭을 활용할 수 있습니다. Ferro는 추론 및 일부 저가형 교육에 사용되는 FPGA 기반 AI 가속기인 Achronix Speedster7t를 강조했습니다.

Ferro는 “에지 AI 애플리케이션에는 HBM과 GDDR 메모리를 위한 공간이 있습니다. HBM은 “에지 애플리케이션에서 계속 사용될 것입니다. HBM의 모든 장점에도 불구하고 3D 기술과 2.5D 제조로 인해 비용이 여전히 높습니다. 이를 감안할 때 GDDR6은 특히 네트워크의 AI 추론에 대해 비용과 성능 간의 좋은 절충안입니다.”

HBM은 Graphcore IPU와 같은 고성능 데이터 센터 AI ASIC에 사용됩니다. 뛰어난 성능을 제공하지만 일부 애플리케이션의 경우 가격이 가파르게 책정될 수 있습니다.

Qualcomm은 이 접근 방식을 사용하는 업체 중 하나입니다. Cloud AI 100은 에지 데이터 센터, 5G "에지 박스", ADAS/자율 주행 및 5G 인프라의 AI 추론 가속화를 목표로 합니다.

Qualcomm의 컴퓨팅 및 에지 클라우드 사업부 총책임자인 Keith Kressin은 "BOM을 낮추고 싶기 때문에 HBM과 달리 표준 DRAM을 사용하는 것이 중요했습니다."라고 말했습니다. “우리는 여러 공급업체로부터 구입할 수 있는 표준 구성 요소를 사용하고 싶었습니다. 모든 것을 온칩으로 처리하려는 고객이 있고 크로스 카드로 전환하려는 고객이 있습니다. 하지만 그들은 모두 합리적인 가격을 원했고 HBM이나 더 이국적인 메모리를 선택하지 않기를 원했습니다.

"훈련 중에는 [여러 칩]을 가로질러 가는 정말 큰 모델이 있지만 추론을 위해 [Cloud AI 100의 시장] 많은 모델이 더 현지화되어 있습니다."

먼 에지

데이터 센터 외부의 에지 AI 시스템은 일반적으로 연합 학습 및 기타 증분 교육 기술과 같은 몇 가지 주목할만한 예외를 제외하고 추론에 중점을 둡니다.

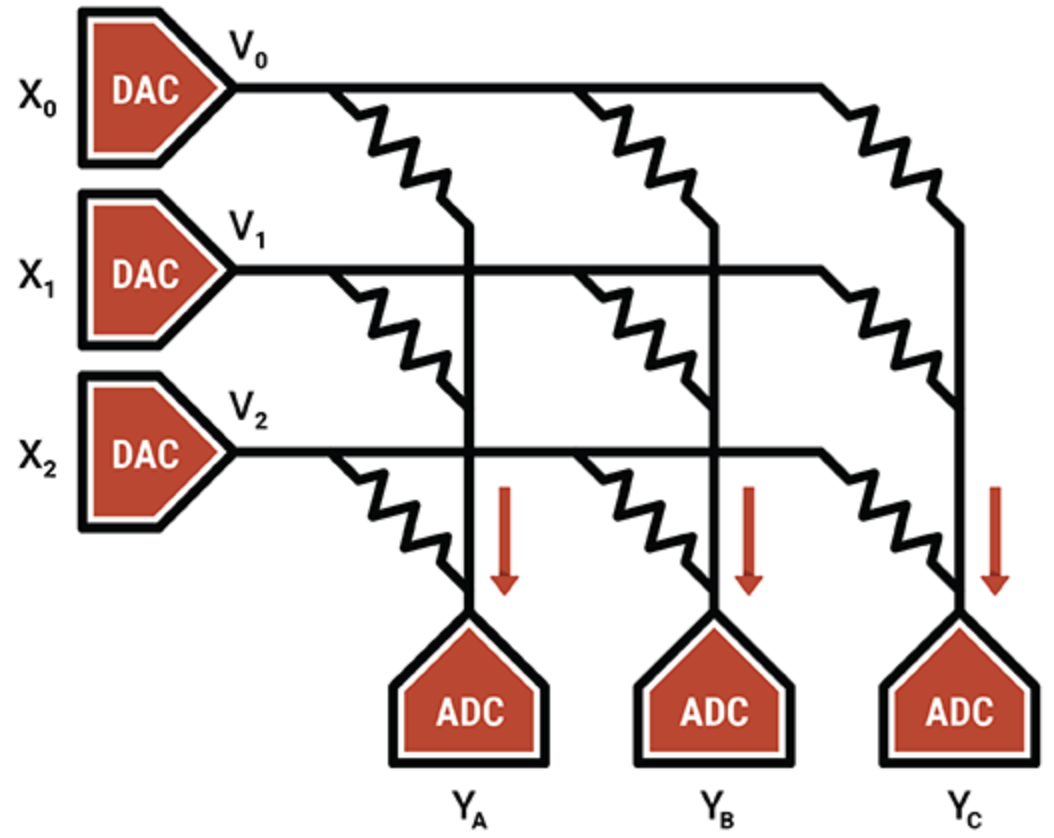

전력에 민감한 애플리케이션을 위한 일부 AI 가속기는 AI 처리를 위해 메모리를 사용합니다. 다차원 행렬 곱셈을 기반으로 하는 추론은 계산을 수행하는 데 사용되는 메모리 셀 어레이를 사용하는 아날로그 계산 기술에 적합합니다. 이 기술을 사용하여 Syntiant의 장치는 가전 제품의 음성 제어용으로 설계되었으며 Gyrfalcon의 장치는 카메라 효과에 대한 추론을 처리하는 스마트폰으로 설계되었습니다.

또 다른 예에서 지능형 처리 장치 전문가인 Mythic은 플래시 메모리 셀의 아날로그 작동을 사용하여 단일 플래시 트랜지스터에 8비트 정수 값(하나의 가중치 매개변수)을 저장하여 다른 메모리 컴퓨팅 기술보다 밀도가 훨씬 높습니다. 프로그래밍된 플래시 트랜지스터는 가변 저항기 역할을 합니다. 입력은 전압으로 공급되고 출력은 전류로 수집됩니다. ADC 및 DAC와 결합하면 효율적인 행렬 곱셈 엔진이 생성됩니다.

Mythic의 IP는 노이즈를 제거하고 안정적인 8비트 계산을 허용하는 보정 및 보정 기술에 있습니다.

메모리 컴퓨팅 장치를 제외하고 ASIC은 특히 저전력 및 초저전력 시스템의 특정 에지 틈새 시장에 널리 사용됩니다. ASIC용 메모리 시스템은 여러 메모리 유형의 조합을 사용합니다. 분산 로컬 SRAM은 가장 빠르고 전력 효율성이 높지만 영역 효율성은 그리 높지 않습니다. 칩에 단일 벌크 SRAM이 있으면 영역 효율성이 더 높지만 성능 병목 현상이 발생합니다. 오프칩 DRAM은 더 저렴하지만 훨씬 더 많은 전력을 사용합니다.

Flex Logix의 CEO인 Geoff Tate는 InferX X1에 대해 분산 SRAM, 벌크 SRAM 및 오프칩 DRAM 간의 올바른 균형을 찾으려면 다양한 성능 시뮬레이션이 필요하다고 말했습니다. 목표는 다이 크기, 패키지 비용 및 사용된 DRAM 수의 함수인 달러당 추론 처리량을 극대화하는 것이었습니다.

“최적의 포인트는 단일 x32 LPDDR4 DRAM이었습니다. 4K MAC(933MHz에서 7.5 TOPS) 그리고 약 10MB SRAM이 필요합니다.”라고 그는 말했습니다. “SRAM은 빠르지만 DRAM에 비해 비싸다. TSMC의 16nm 공정 기술을 사용하면 1MB의 SRAM이 약 1.1mm 2 필요합니다. . “저희 InferX X1은 54mm 2 입니다. 그리고 우리의 아키텍처로 인해 DRAM 액세스는 계산과 크게 겹치므로 성능 구성이 없습니다. 단일 DRAM을 사용하는 대형 모델의 경우 적어도 우리 아키텍처에서는 적절한 절충안이 필요합니다.”라고 Tate가 말했습니다.

Flex Logix 칩은 대기 시간이 짧은 스트리밍 비디오 분석을 포함하여 실시간 작업이 필요한 에지 AI 추론 애플리케이션에 사용됩니다. 여기에는 ADAS 시스템, 보안 영상 분석, 의료 영상 및 품질 보증/검사 애플리케이션이 포함됩니다.

이러한 애플리케이션에서 InferX X1과 함께 어떤 종류의 DRAM이 들어갈까요?

"우리는 LPDDR이 가장 인기가 있을 것이라고 생각합니다. 단일 DRAM은 10GB/초 이상의 대역폭을 제공하지만 가중치/중간 활성화를 저장하기에 충분한 비트를 가지고 있습니다."라고 Tate가 말했습니다. "다른 DRAM에는 더 많은 칩과 인터페이스가 필요하며 사용되지 않는 비트는 더 많이 구매해야 합니다."

여기에 새로운 메모리 기술을 위한 여지가 있습니까?

그는 “이머징 메모리를 사용할 때 웨이퍼 비용이 극적으로 올라가는 반면 SRAM은 실리콘 영역을 제외하고는 '무료'다. "경제가 변하면 티핑 포인트도 변할 수 있지만 더 멀어질 것입니다."

새롭게 떠오르는 추억

규모의 경제에도 불구하고 다른 메모리 유형은 AI 애플리케이션의 미래 가능성을 보유하고 있습니다.

MRAM(자기 저항 RAM)은 인가된 전압에 의해 제어되는 자석의 방향을 통해 데이터의 각 비트를 저장합니다. 전압이 비트를 뒤집는 데 필요한 것보다 낮으면 비트가 뒤집힐 가능성만 있습니다. 이러한 임의성은 원하지 않으므로 MRAM은 이를 방지하기 위해 더 높은 전압으로 구동됩니다. 그래도 일부 AI 애플리케이션은 이러한 고유한 확률(데이터를 무작위로 선택하거나 생성하는 프로세스로 생각할 수 있음)을 활용할 수 있습니다.

실험을 통해 MRAM의 확률 기능을 Gyrfalcon의 장치에 적용했는데, 모든 가중치 및 활성화의 정밀도를 1비트로 줄이는 기술입니다. 이는 최첨단 애플리케이션에 대한 컴퓨팅 및 전력 요구 사항을 크게 줄이는 데 사용됩니다. 네트워크를 재훈련하는 방법에 따라 정확성과 타협할 가능성이 있습니다. 일반적으로 신경망은 정밀도가 낮아도 안정적으로 작동하도록 만들 수 있습니다.

Spin Memory의 제품 부사장인 Andy Walker는 "이진화된 신경망은 숫자가 -1 또는 +1이라는 확실성이 감소하더라도 안정적으로 작동할 수 있다는 점에서 독특합니다."라고 말했습니다. "우리는 이러한 BNN이 부정확하게 기록되는 메모리 비트의 '비트 오류율'을 도입함으로써 이러한 확실성이 감소하기 때문에 여전히 높은 수준의 정확도로 작동할 수 있음을 발견했습니다."

MRAM은 낮은 전압 수준에서 제어된 방식으로 비트 오류율을 자연스럽게 도입하여 정확도를 유지하면서 전력 요구 사항을 더욱 낮출 수 있습니다. 핵심은 가장 낮은 전압과 최단 시간에 최적의 정확도를 결정하는 것입니다. Walker는 이것이 가장 높은 에너지 효율성을 의미한다고 말했습니다.

이 기술은 고정밀 신경망에도 적용되지만 MRAM 셀에는 BNN의 이진 상태와 일치하는 두 가지 상태가 있기 때문에 특히 BNN에 적합합니다.

Walker에 따르면 엣지에서 MRAM을 사용하는 것도 또 다른 잠재적인 애플리케이션입니다.

그는 “에지 AI의 경우 MRAM은 고성능 정확도가 요구되지 않는 애플리케이션에서 더 낮은 전압에서 실행할 수 있지만 에너지 효율성과 메모리 내구성 향상이 매우 중요하다”고 말했다. “또한 MRAM의 고유한 비휘발성으로 인해 전원 없이 데이터를 보존할 수 있습니다.

한 가지 애플리케이션은 "이 새로운 메모리가 임베디드 플래시와 SRAM 교체 모두의 역할을 할 수 있어 다이의 영역을 절약하고 SRAM 고유의 정적 전력 손실을 방지할 수 있는" 소위 통합 메모리입니다.

Spin Memory의 MRAM이 상업적으로 채택되기 직전이지만 BNN의 특정 구현은 기본 MRAM 셀의 변형에서 가장 잘 작동합니다. 따라서 연구 단계에 머물러 있습니다.

뉴로모픽 ReRAM

엣지 AI 애플리케이션을 위한 또 다른 새로운 메모리는 ReRAM입니다. Politecnico Milan의 최근 연구는 Weebit Nano의 산화규소(SiOx) ReRAM 기술을 사용하여 뉴로모픽 컴퓨팅에 대한 가능성을 보여주었습니다. ReRAM은 신경망 하드웨어에 가소성의 차원을 추가했습니다. 즉, 조건이 변경됨에 따라 진화할 수 있습니다. 즉, 뉴로모픽 컴퓨팅에서 유용한 품질입니다.

현재의 신경망은 훈련된 작업을 잊지 않고는 학습할 수 없지만 뇌는 이를 아주 쉽게 수행할 수 있습니다. AI 용어로 이것은 알고리즘이 레이블이 없는 데이터 세트에서 추론을 수행하고 데이터에서 고유한 패턴을 찾는 "비지도 학습"입니다. 최종 결과는 현장에서 새로운 작업을 학습하고 주변 환경에 적응할 수 있는 ReRAM 지원 에지 AI 시스템이 될 수 있습니다.

전반적으로 메모리 제조업체는 AI 애플리케이션에 필요한 속도와 대역폭을 제공하는 기술을 도입하고 있습니다. AI 컴퓨팅과 동일한 칩, 동일한 패키지 또는 별도의 모듈에 있는 다양한 메모리는 많은 에지 AI 애플리케이션에 맞게 사용할 수 있습니다.

에지 AI용 메모리 시스템의 정확한 특성은 애플리케이션에 따라 다르지만 GDDR, HBM 및 Optane은 데이터 센터에 널리 사용되고 있는 반면 LPDDR은 엔드포인트 애플리케이션에 대해 온칩 SRAM과 경쟁합니다.

새로운 기억은 미래의 전력 효율이 높고 두뇌에서 영감을 받은 시스템을 가능하게 하기 위해 오늘날 하드웨어의 능력을 넘어 신경망을 발전시키도록 설계된 연구에 새로운 속성을 부여하고 있습니다.

>> 이 기사는 원래 다음 날짜에 게시되었습니다. 자매 사이트인 EE Times.

임베디드

스마트 자동차, 스마트 홈 장치 및 연결된 산업 장비의 수와 인기가 증가함에 따라 거의 모든 곳에서 데이터를 생성합니다. 실제로 2022년에는 전 세계적으로 164억 개 이상의 IoT(사물 인터넷) 장치가 연결되어 있으며 그 수는 2025년까지 309억 개까지 급증할 것으로 예상됩니다. 그때까지 IDC는 이러한 장치가 전 세계적으로 73.1제타바이트의 데이터를 생성할 것으로 예측합니다. 멀지 않은 2019년에 비해 300% 성장했습니다. 이 데이터를 빠르고 효과적으로 정렬하고 분석하는 것은 최적의 애플리케이션 사용자 경험과 더

5월에 게시됨. 2020년 5월 5일 | 작성자:Arion, 프로젝트 관리자 시장의 필요는 언제든지 변하고 있습니다. 이러한 빠르게 변화하는 기술에 더 잘 적응하기 위해 제조 기술은 지속적으로 업데이트되고 업그레이드됩니다. 경쟁 우위를 유지하기 위해 제조업체는 속도를 따라가지 않으면 산업 업그레이드 과정에서 탈락할 위험에 직면해야 합니다. 기술 업그레이드 과정은 분명히 고통스러울 수 있지만 기업의 장기적인 발전을 위해서는 매우 중요합니다. 이 기사는 마이크로 밀링 기술에 대해 배우기 위해 함께 할 것입니다. 마이크로 밀링의 이해